Transformer vs anciens modèles NLP

Transformer vs anciens modèles de traitement du langage

Publiée le septembre 24, 2025

Transformer vs anciens modèles de traitement du langage

Publiée le septembre 24, 2025

Mécanisme central : auto-attention (self-attention)

→ Le modèle “regarde” tous les mots en parallèle et apprend quelles relations sont importantes, même à longue distance.

Parallélisation massive : pas de traitement strictement séquentiel comme dans les Réseaux de Neurones Récurrents (RNN, Recurrent Neural Networks) → entraînement beaucoup plus rapide sur Unités de Traitement Graphique (GPU, Graphics Processing Units) et Unités de Traitement Tensoriel (TPU, Tensor Processing Units).

Contexte long : gère de grandes fenêtres contextuelles (des milliers de tokens), là où RNN et variantes perdent la mémoire distante.

Échelle (scalabilité) : se dimensionne très bien (paramètres, données, calcul) → d’où les Grands Modèles de Langage (LLM, Large Language Models) modernes.

Flexibilité : s’étend au multimodal (texte, image, audio), au in-context learning et au raffinage/fine-tuning efficace.

Limites toujours vraies côté Transformer

Coût quadratique avec la longueur de contexte (attention “classique”) → mémoire et calcul élevés.

Besoin important de données et de calcul pour les très grands modèles.

Moins de biais inductifs locaux que les Réseaux de Neurones Convolutifs (CNN, Convolutional Neural Networks) qui captent naturellement les motifs locaux.

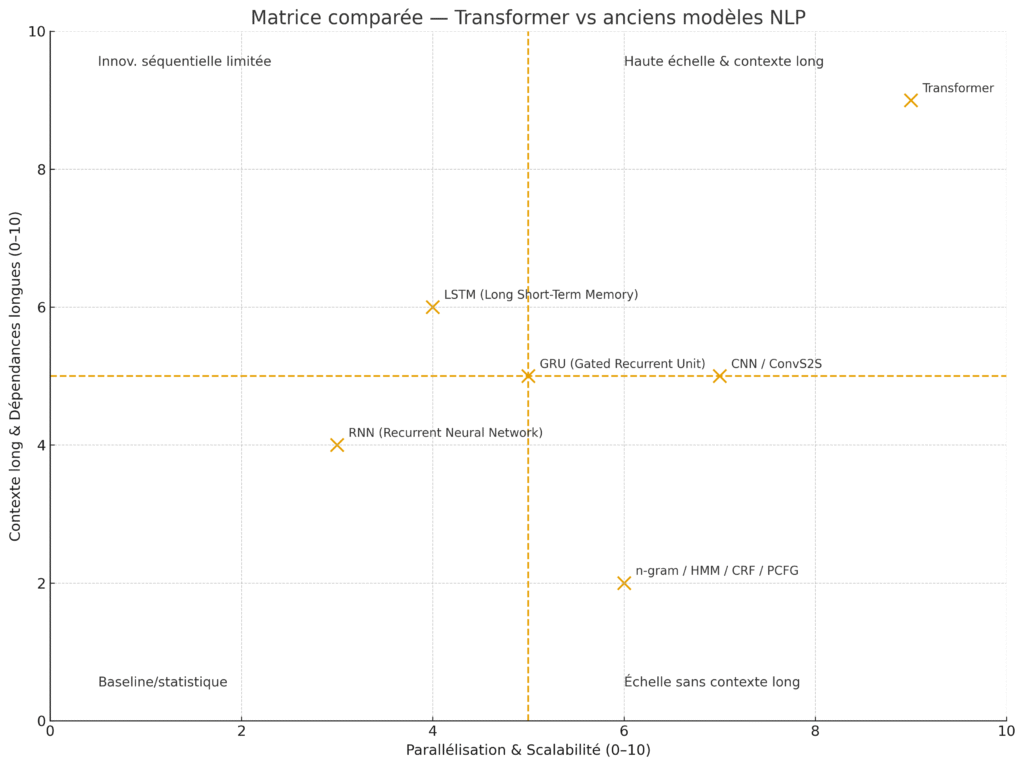

RNN — Recurrent Neural Networks (Réseaux de Neurones Récurrents) : traitent mot par mot ; difficulté à mémoriser le long terme (vanishing/exploding gradients).

LSTM — Long Short-Term Memory (Mémoire à Long et Court Terme) : ajoute des portes pour mieux mémoriser → longtemps l’état de l’art en traduction et parole.

GRU — Gated Recurrent Unit (Unité Récurrente à Portes) : variante plus légère du LSTM.

Seq2Seq — Sequence-to-Sequence avec attention (Bahdanau/Luong) : premier grand saut en traduction ; l’attention y est un module, pas l’architecture entière.

CNN/ConvS2S — Convolutional Neural Networks / Convolutional Sequence-to-Sequence : parallélisables localement, bons sur les motifs locaux, moins à l’aise avec les dépendances très longues.

(WaveNet pour l’audio : architecture convolutionnelle générative).

Modèles n-grammes (modèles de langage par comptage),

HMM — Hidden Markov Models (Modèles de Markov Cachés) pour l’étiquetage de séquences,

CRF — Conditional Random Fields (Champs Aléatoires Conditionnels) pour l’étiquetage structuré,

PCFG — Probabilistic Context-Free Grammars (Grammaires Hors-Contexte Probabilistes).

→ Peu de compréhension sémantique, forte ingénierie de features, performances limitées.

| Dimension | Transformer | RNN/LSTM/GRU | CNN/ConvS2S | n-gram/HMM/CRF/PCFG |

|---|---|---|---|---|

| Traitement | Parallèle (auto-attention) | Séquentiel (état caché récurrent) | Parallèle local (filtres) | Comptage/statistiques |

| Dépendances longues | Excellentes | Difficiles (gradients) | Moyennes | Faibles |

| Vitesse d’entraînement | Haute (GPU/TPU-friendly) | Plus lente | Haute | Haute |

| Contexte long | Large fenêtre (↑ tokens) | Limité | Limité-moyen | Très limité |

| Scalabilité LLM | Très bonne | Limitée | Moyenne | N/A |

| Données requises | Élevées | Moindres | Moindres | Moindres |

| Coût mémoire/compute | Élevé (attention) | Modéré | Modéré | Faible |

| Biais inductifs locaux | Plus faibles | — | Forts | — |

Forte contrainte de ressources (embarqué/edge, petits jeux de données) → GRU/LSTM restent pertinents.

Motifs locaux dominants (petites séquences, patterns réguliers) → CNN/ConvS2S efficaces, simples et rapides.

Pipelines historiques d’étiquetage (peu de données, besoin d’interprétabilité) → CRF/HMM encore utiles.